在本地部署 DeepSeek-R1:2025 年 Intel vs AMD CPU 對決

根據成本、速度和擴充性選擇合適的處理器

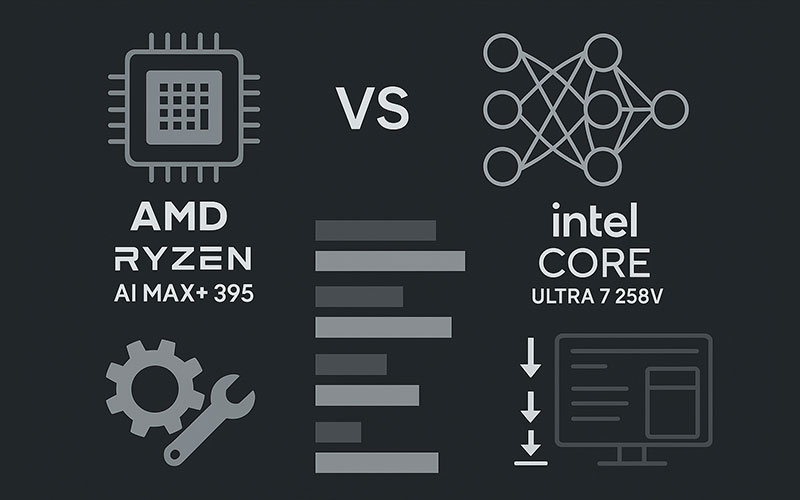

隨著 DeepSeek-R1 等開放原始碼 LLM 在裝置上人工智慧領域逐漸受到重視,選擇正確的 CPU 就變得非常重要 - 尤其是在 Intel 的 Lunar Lake 和 AMD 的 Ryzen AI Max+ 395 佔據市場的情況下。以下是它們在實際 R1 部署上的比較。

⚙️ 部署 DeepSeek-R1 的關鍵標準

- 在比較 CPU 之前,請先瞭解 R1 的需求:

- 令牌吞吐量:令牌吞吐量:令牌/秒(更高 = 反應更快)

- First-token 延遲:輸出開始前的延遲 (對 UX 而言非常重要)

- 模型尺寸支援:R1 蒸餾範圍從 1.5B → 70B 參數 67

- 記憶體頻寬:對於大型模型載入至關重要

電源效率:每個令牌的瓦特數 ($$ 隨時間變化)

效能對決:AMD Ryzen AI Max+ 395 vs Intel Core Ultra 7 258V

使用 DeepSeek-R1-Distill-Qwen-14B 進行的獨立基準測試顯示出明顯的差異:

| 公制 | AMD Ryzen AI Max+ 395 | Intel Core Ultra 7 258V | AMD 優勢 |

|---|---|---|---|

| 代幣/秒 (Qwen-14B) | 142 t/s | 64 t/s | 快 2.2 倍 |

| 第一個代碼延遲 | 0.7 秒 | 3.1 秒 | 低 4.4 倍 |

| 最大模型大小 (RAM) | 70B (64GB RAM) | 32B (32GB RAM) | 大 2.2 倍 |

| 耗電量(持續) | 28W (FP16 操作) | 33W | 15% 下缸体 |

→ *資料來源:AMD 公開基準 (LM Studio v0.3.8 + DeepSeek-R1-Distill-Qwen-14B @ FP4)* 46

為何 AMD 在吞吐量上勝出:

- Zen 5 + RDNA 3.5 iGPU 搭配 50 TOPS NPU 加速量化作業

- 更高的可配置 TDP(高達 120W)→持續效能 4

- 適用於 DeepSeek-R1 的最佳化 ROCm 堆疊 + LM Studio 整合

Intel 的優勢:

- 超低功耗模式 (10-15W) 的競爭力

- 針對以 Windows 為中心的工作流程提供更好的驅動程式支援

💡 部署情境:哪種 CPU 適用於您的使用個案?

✅ 如果您需要,請選擇 AMD Ryzen AI Max+:

- 大型機型:在本地運行多達 70B-param R1 蒸餾(例如,DeepSeek-R1-Distill-Llama-70B) 6

- 低延遲:聊天機器人、編碼助理、即時分析的關鍵

- Linux/ROCm 環境:AMD 的開放原始碼 AI 堆疊與 R1 的 MIT 授權一致

- 預算規模:較便宜的代幣 → 長期較低的雲端成本

✅ 如果您喜歡,請選擇 Intel Lunar Lake:

- Windows 整合:與 DirectML、WSL2、Edge AI 無縫整合

- 企業支援:採用 Intel 最佳化 Kubernetes 的 IT 管理資料中心

- 輕薄型筆記型電腦:在 25 瓦 TDP 之下,每瓦效能更佳

🛠️ Step-by-Step:在 AMD 上部署 DeepSeek-R1

*(以 Ryzen AI Max+ 395 + 64GB 記憶體測試)*。

安裝驅動程式:

→ AMD Adrenalin 25.1.1+ & ROCm 7.x 6

下載 LM Studio (v0.3.8 以上),並選擇一個蒸餾的 R1 模型:

型號:DeepSeek-R1-Distill-Qwen-32B

數量:Q4_K_M (建議用於速度/精度平衡)

在 LM Studio 中最大化 GPU 卸載:

# 在 LM Studio 設定中:

GPU_OFFLOAD = "Max" # 使用 NPU + iGPU + RAM

負載 → 聊天!*(First-token latency as low as 0.7s)* 6

未來展望:基於 CPU 的 R1 部署發展方向

- AMD 的領先優勢越來越大:MI350X GPU 目前執行 R1 30% 的速度快於 NVIDIA B200 810

- Intel 反擊:"Panther Lake」CPU(2025 年底)承諾可提升 3 倍的 NPU 效能

- 混合雲端與 CPU 的工作流程:CPU 上的輕量級 R1-8B + 雲端上的繁重任務

💎底線

適用於高效能、高成本效益的 DeepSeek-R1 部署:

- AMD Ryzen AI Max+ 395 是今天的贏家 - 尤其是在 Linux/ROCm 設定中。

適用於以 Windows 為中心或電源有限的邊緣用途:

- Intel Lunar Lake 依然可行,但在原始吞吐量方面卻落後於人。

專業建議:搭配 AMD CPU 與 RX 7000 GPU(例如 7900 XTX),即可在桌上型電腦規模 6 下執行 32B+ R1 模型。

為什麼這很重要

DeepSeek-R1 不只是另一個 LLM - 它比 OpenAI o1 便宜 96.4%,但推理能力卻與 OpenAI o1 不相伯仲。在 CPU/GPU 混合器上進行最佳部署,可將 AI 開放給初創公司、研究人員以及被 GPU 軍備競賽鎖定在外的全球開發人員。

Intel 並未出局,但在 2025 年,AMD 才是裝置上 R1 的務實選擇。

(需要部署方面的協助嗎?我可以指導您針對您的硬體進行配置!)