NVIDIA HGX H100 4/8-GPU AI Server: Powerhouse for Deep Learning & HPC

Unlock Unprecedented AI Training Performance

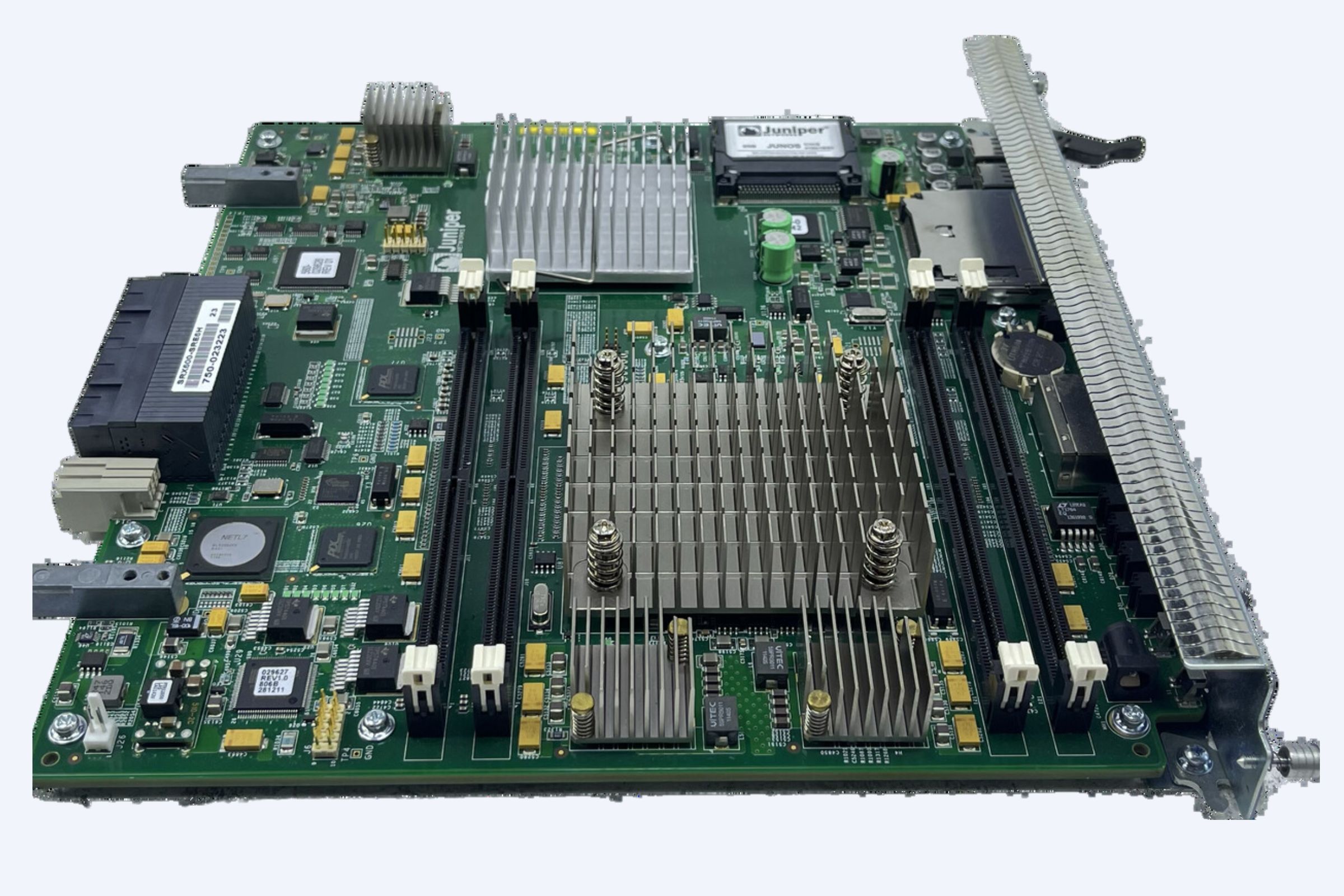

This cutting-edge NVIDIA HGX H100 server platform is engineered for the most demanding deep learning training, high-performance computing (HPC), and large-scale AI workloads. Configured with either 4 or 8 state-of-the-art NVIDIA H100 Tensor Core GPUs (available in 40GB or 80GB versions), it delivers exceptional computational density and breakthrough acceleration.

Core Specifications:

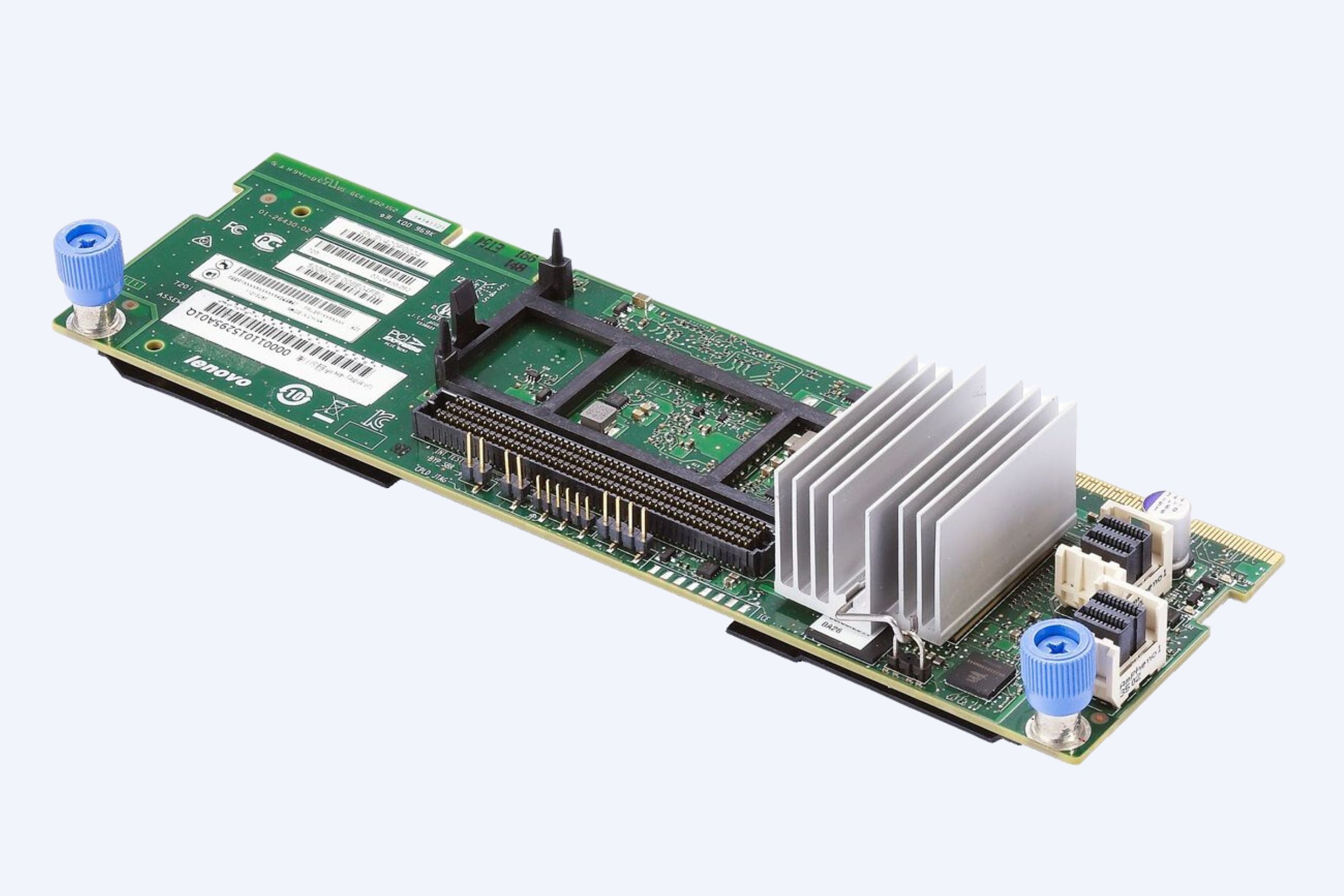

- GPU Configuration: Choice of 4x or 8x NVIDIA H100 GPUs (HGX H100 4-GPU or 8-GPU baseboard)

- GPU Memory: High-Bandwidth 40GB or 80GB per H100 GPU (HBM2e technology)

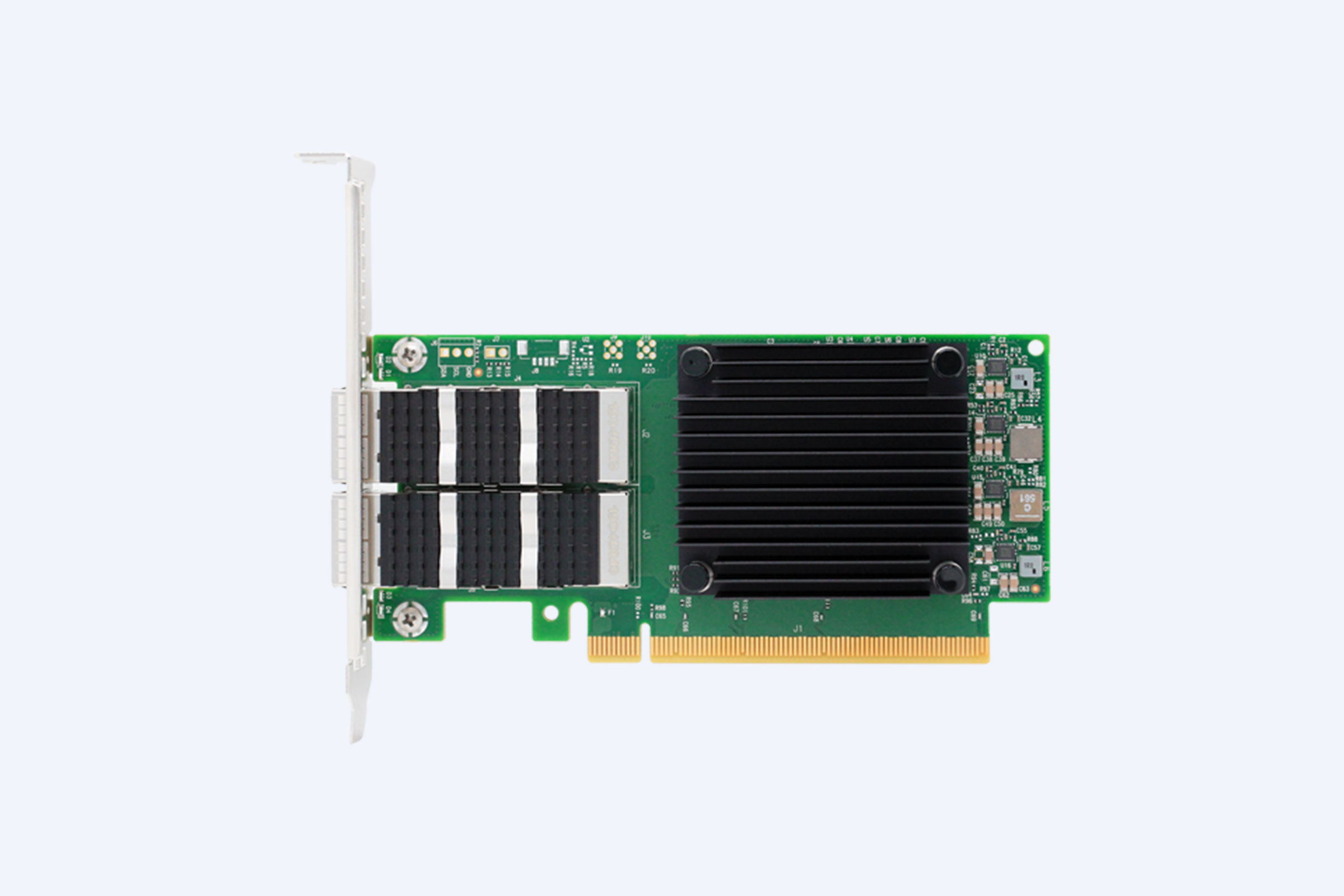

- GPU Interconnect: NVIDIA NVLink® and NVSwitch® technology enabling ultra-fast GPU-to-GPU communication crucial for large model training.

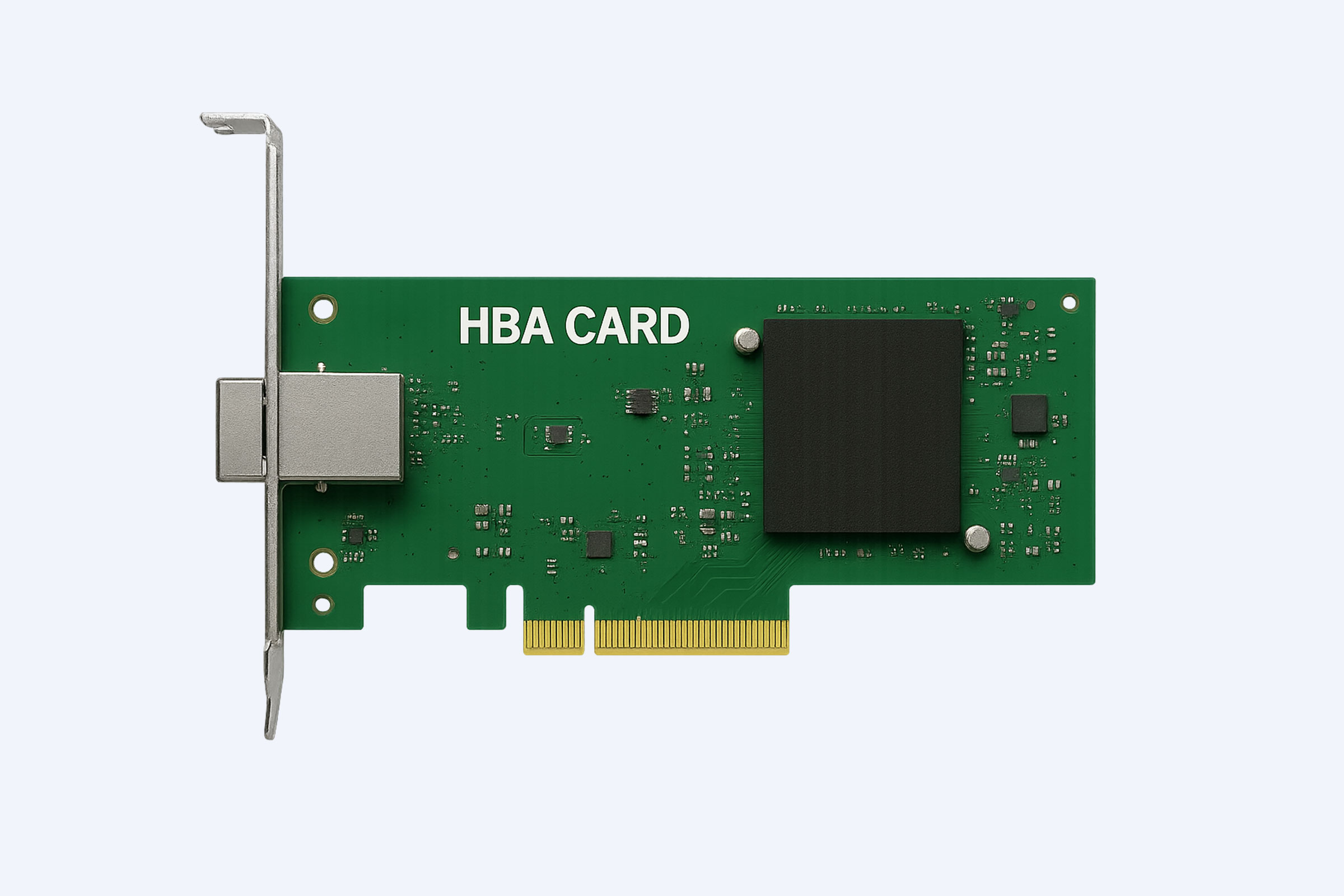

- System Interface: PCI Express (Latest generation support expected)

- Cooling: Robust Active Fan cooling solution ensuring optimal thermal management under sustained heavy loads.

- Application: Designed for Enterprise Workstations & Data Center deployment.

- Chipset: Based on the revolutionary NVIDIA Hopper™ architecture.

- Place of Origin: Components sourced from US/Taiwan (TW).

- Supplier: szwecent.com

Key Advantages:

- Massive Parallel Processing: 4 or 8 H100 GPUs provide unparalleled parallel compute power for accelerating complex neural network training.

- Large Memory Capacity: 40GB or 80GB per GPU (320GB/640GB total for 8x80GB) handles massive datasets and enormous models like Large Language Models (LLMs).

- Breakthrough Speed: Hopper architecture features like the Transformer Engine and FP8 precision dramatically accelerate AI training times.

- Optimized AI Stack: Fully compatible with leading AI frameworks (TensorFlow, PyTorch) and NVIDIA software stack (CUDA®, cuDNN, NCCL).

- Scalability: HGX platform design enables integration into larger clusters for extreme-scale AI.

เหมาะสำหรับ:

- Training Large Language Models (LLMs – GPT, BERT, etc.)

- Deep Learning Research & Development

- High-Performance Computing (HPC) Simulations

- Accelerated Data Analytics

- Complex Scientific Computing

Condition Options: Available to suit your needs: Brand New, Used, Refurbished, OPEN-BOX, or Ready-to-Ship configurations.

Experience the Next Level of AI Performance.

This NVIDIA HGX H100 server represents the pinnacle of AI infrastructure, offering the computational horsepower necessary to push the boundaries of what’s possible in deep learning and scientific discovery. Choose your optimal GPU count (4 or 8) and memory configuration (40GB or 80GB per GPU) to match your ambitious workload requirements.

| ข้อมูลจำเพาะ | รายละเอียด |

|---|---|

| นาฬิกาแกนกลาง | ต้นฉบับ |

| นาฬิกาความจำ | ต้นฉบับ |

| ประเภทหน่วยความจำวิดีโอ | GDDR7 |

| อินเทอร์เฟซหน่วยความจำ | ต้นฉบับ |

| การสนับสนุน DirectX | ไดเรกต์เอ็กซ์ 7 |

| ประเภทอินเทอร์เฟซ | พีซีไอ เอ็กซ์เพรส |

| อินเทอร์เฟซเอาท์พุต | ต้นฉบับ |

| ประเภทเครื่องทำความเย็น | พัดลม |

| กระบวนการชิป | ต้นฉบับ |

| ชื่อสินค้า | การ์ดจอ การ์ดจอ |

| รุ่นของจีพียู | HGX A100 4/8 จีพียู 40GB 80G, HGX H100 4/8 จีพียู 40GB 80G |

| แอปพลิเคชัน | เวิร์คสเตชั่น |

| เงื่อนไข | มือสอง ใหม่ ปรับปรุงใหม่ เปิดกล่อง พร้อมใช้งาน |

| ยี่ห้อ | เอ็นวิเดีย |

| Supplier | szwecent.com |

| แหล่งกำเนิดสินค้า | สหรัฐอเมริกา/ไต้หวัน |

| แม่พิมพ์ส่วนตัว | เลขที่ |

รีวิว

ยังไม่มีบทวิจารณ์