DeepSeek-R1 lokaal implementeren: Intel vs AMD CPU krachtmeting in 2025

De juiste processor kiezen voor kosten, snelheid en schaalbaarheid

Nu open-source LLM's zoals DeepSeek-R1 aan populariteit winnen voor on-device AI, wordt het kiezen van de juiste CPU cruciaal - vooral nu Intel's Lunar Lake en AMD's Ryzen AI Max+ 395 de markt domineren. Dit is hoe ze zich verhouden tot echte R1 implementaties.

⚙️ Belangrijkste criteria voor het implementeren van DeepSeek-R1

- Voordat je CPU's gaat vergelijken, moet je de eisen van R1 begrijpen:

- Doorvoer tokens: Tokens/sec (hoger = snellere reacties)

- Eerste token latentie: Vertraging voordat de uitvoer begint (cruciaal voor UX)

- Ondersteuning modelgrootte: R1 destillaties variëren van 1,5B → 70B parameters 67

- Geheugenbandbreedte: Cruciaal voor het laden van grote modellen

Energie-efficiëntie: Watt per token ($$ na verloop van tijd)

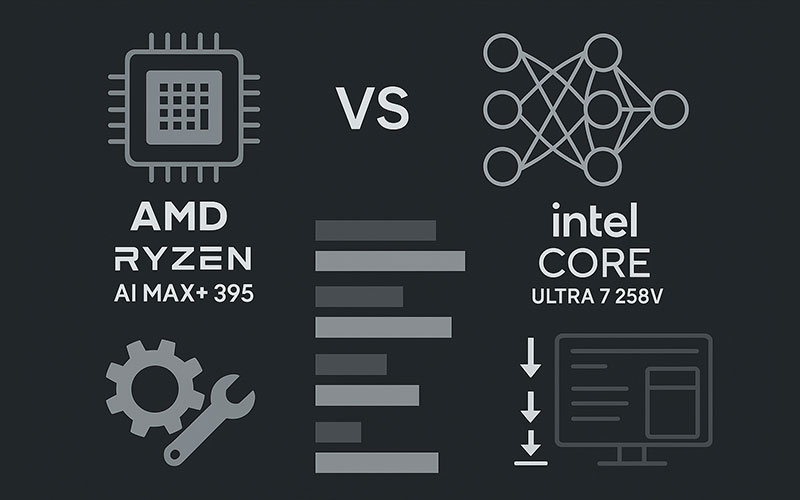

Prestaties face-off: AMD Ryzen AI Max+ 395 vs Intel Core Ultra 7 258V

Onafhankelijke benchmarks met DeepSeek-R1-Distill-Qwen-14B laten sterke verschillen zien:

| Metrisch | AMD Ryzen AI Max+ 395 | Intel Core Ultra 7 258V | AMD Voordeel |

|---|---|---|---|

| Tokens/sec (Qwen-14B) | 142 t/s | 64 t/s | 2,2× sneller |

| Wachttijd eerste token | 0,7 sec | 3,1 sec | 4,4× lager |

| Max. grootte model (RAM) | 70B (64 GB RAM) | 32B (32 GB RAM) | 2,2× groter |

| Stroomverbruik (continu) | 28W (FP16 ops) | 33W | 15% lager |

→ *Bron: Openbare AMD-benchmarks (LM Studio v0.3.8 + DeepSeek-R1-Distill-Qwen-14B @ FP4)* 46

Waarom AMD wint op doorvoer:

- Zen 5 + RDNA 3.5 iGPU met 50 TOPS NPU versnelt gekwantificeerde ops

- Hogere configureerbare TDP (tot 120 W) → aanhoudende prestaties 4

- Geoptimaliseerde ROCm-stack + LM Studio-integratie voor DeepSeek-R1

Waar Intel standhoudt:

- Concurrerend in ultra-low-power modi (10-15W)

- Betere driverondersteuning voor Windows-gerichte workflows

Inzetscenario's: Welke CPU voor uw toepassing?

Kies AMD Ryzen AI Max+ als je dat nodig hebt:

- Grote modellen: Voer tot 70B-param R1-distillaties lokaal uit (bijv. DeepSeek-R1-Distill-Llama-70B) 6

- Lage latentie: Essentieel voor chatbots, codeerassistenten, real-time analyse

- Linux/ROCm-omgevingen: AMD's open-source AI-stack sluit aan bij R1's MIT-licentie

- Budgettaire schaal: Goedkopere tokens → lagere cloudkosten op lange termijn

Kies Intel Lunar Lake als je dat liever hebt:

- Integratie met Windows: Naadloos met DirectML, WSL2, Edge AI

- Ondersteuning voor bedrijven: Door IT beheerde datacenters met voor Intel geoptimaliseerde Kubernetes

- Dunne en lichte laptops: Betere perf-per-watt onder 25W TDP

🛠️ Stap voor stap: DeepSeek-R1 implementeren op AMD

*(Getest op Ryzen AI Max+ 395 + 64 GB RAM)*

Stuurprogramma's installeren:

→ AMD Adrenaline 25.1.1+ & ROCm 7.x 6

Download LM Studio (v0.3.8+) en selecteer een gedistilleerd R1-model:

Model: DeepSeek-R1-Distill-Qwen-32B

Quant: Q4_K_M (aanbevolen voor snelheid/nauwkeurigheidsbalans)

GPU offload maximaliseren in LM Studio:

# In LM Studio instellingen:

GPU_OFFLOAD = "Max" # Gebruikt NPU + iGPU + RAM

Laden → chat! *(Eerste token latentie zo laag als 0,7s)* 6

Toekomstperspectief: Waar CPU-gebaseerde R1-implementatie naartoe gaat

- AMD's voorsprong groeit: MI350X GPU's draaien nu R1 30% sneller dan NVIDIA B200 810

- Intel vecht terug: "Panther Lake CPU's (eind 2025) beloven 3× NPU-winst

- Hybride cloud-CPU-workflows: Lichtgewicht R1-8B op CPU + zware taken op cloud

De kern van de zaak

Voor een krachtige, kostenefficiënte inzet van DeepSeek-R1:

- AMD Ryzen AI Max+ 395 is de winnaar van vandaag - vooral in Linux/ROCm-opstellingen.

Voor randgebruik waarbij Windows centraal staat of het vermogen beperkt is:

- Intel Lunar Lake blijft levensvatbaar, maar blijft achter in ruwe doorvoer.

Pro tip: koppel AMD CPU's met RX 7000 GPU's (bijvoorbeeld 7900 XTX) om 32B+ R1-modellen op desktopschaal 6 te draaien.

Waarom dit belangrijk is

DeepSeek-R1 is niet zomaar een LLM - het is 96,4% goedkoper dan OpenAI o1 terwijl het zijn redeneerkracht 1 evenaart. Door het optimaal in te zetten op CPU/GPU-mengsels wordt AI toegankelijk voor startups, onderzoekers en wereldwijde ontwikkelaars die zijn uitgesloten van de GPU-wapenwedloop.

Intel is nog niet uit, maar in 2025 is AMD de pragmatische keuze voor on-device R1.

(Heb je hulp nodig bij het implementeren? Ik kan je helpen bij het configureren van je hardware!)