DeepSeek-R1 로컬 배포: 2025년 인텔 대 AMD CPU 대결

비용, 속도, 확장성에 적합한 프로세서 선택하기

특히 인텔의 루나 레이크와 AMD의 라이젠 AI 맥스+ 395가 시장을 장악하고 있는 가운데, 딥시크-R1과 같은 오픈 소스 LLM이 온디바이스 AI를 위해 주목받으면서 올바른 CPU를 선택하는 것이 중요해졌습니다. 실제 R1 배포를 위해 이 두 가지를 비교하는 방법은 다음과 같습니다.

⚙️ DeepSeek-R1 배포를 위한 주요 기준

- CPU를 비교하기 전에 R1의 요구 사항을 이해하세요:

- 토큰 처리량: 토큰/초 (높을수록 빠른 응답)

- 첫 번째 토큰 지연 시간: 출력 시작 전 지연 시간(UX에 중요)

- 모델 크기 지원: R1 증류 범위: 1.5B → 70B 파라미터 67

- 메모리 대역폭: 대용량 모델 로딩에 필수적인 요소

전력 효율성: 토큰당 와트(시간 경과에 따른 $$)

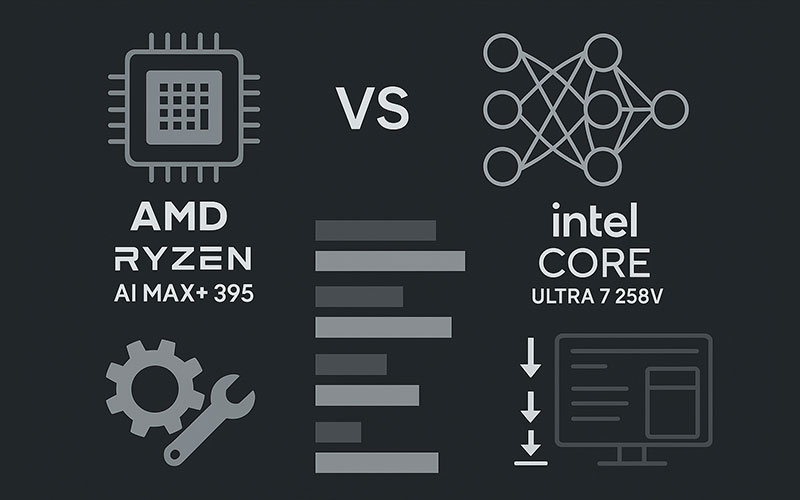

성능 대결: AMD Ryzen AI Max+ 395 vs Intel Core Ultra 7 258V

DeepSeek-R1-Distill-Qwen-14B를 사용한 독립적인 벤치마크에서는 뚜렷한 차이가 드러납니다:

| Metric | AMD Ryzen AI Max+ 395 | 인텔 코어 울트라 7 258V | AMD 장점 |

|---|---|---|---|

| 토큰/초(Qwen-14B) | 142 t/s | 64 t/s | 2.2배 빨라진 속도 |

| 첫 번째 토큰 지연 시간 | 0.7초 | 3.1초 | 4.4배 더 낮음 |

| 최대 모델 크기(RAM) | 70B(64GB RAM) | 32B(32GB RAM) | 2.2배 더 커짐 |

| 전력 소모량(지속) | 28W(FP16 운영) | 33W | 15% 더 낮음 |

→ *소스: AMD 공개 벤치마크(LM Studio v0.3.8 + DeepSeek-R1-Distill-Qwen-14B @ FP4)* 46

AMD가 처리량에서 승리하는 이유:

- 양자화된 작업을 가속화하는 Zen 5 + RDNA 3.5 iGPU(50 TOPS NPU 포함)

- 더 높은 구성 가능 TDP(최대 120W) → 지속적인 성능 4

- DeepSeek-R1에 최적화된 ROCm 스택 + LM Studio 통합

인텔이 견디는 곳:

- 초저전력 모드(10-15W)에서 경쟁력 확보

- Windows 중심 워크플로우를 위한 드라이버 지원 개선

💡 배포 시나리오: 사용 사례에 적합한 CPU는?

✅ 필요한 경우 AMD Ryzen AI Max+를 선택하십시오:

- 대형 모델: 로컬에서 최대 70B 매개변수 R1 증류 실행(예: DeepSeek-R1-Distill-Llama-70B) 6

- 짧은 지연 시간: 챗봇, 코딩 어시스턴트, 실시간 분석에 필수적인 요소

- Linux/ROCm 환경: AMD의 오픈 소스 AI 스택은 R1의 MIT 라이선스와 일치합니다.

- 예산 규모: 더 저렴한 토큰 → 장기적으로 클라우드 비용 절감

✅ 원하는 경우 인텔 루나레이크를 선택하세요:

- Windows 통합: DirectML, WSL2, Edge AI와의 원활한 통합

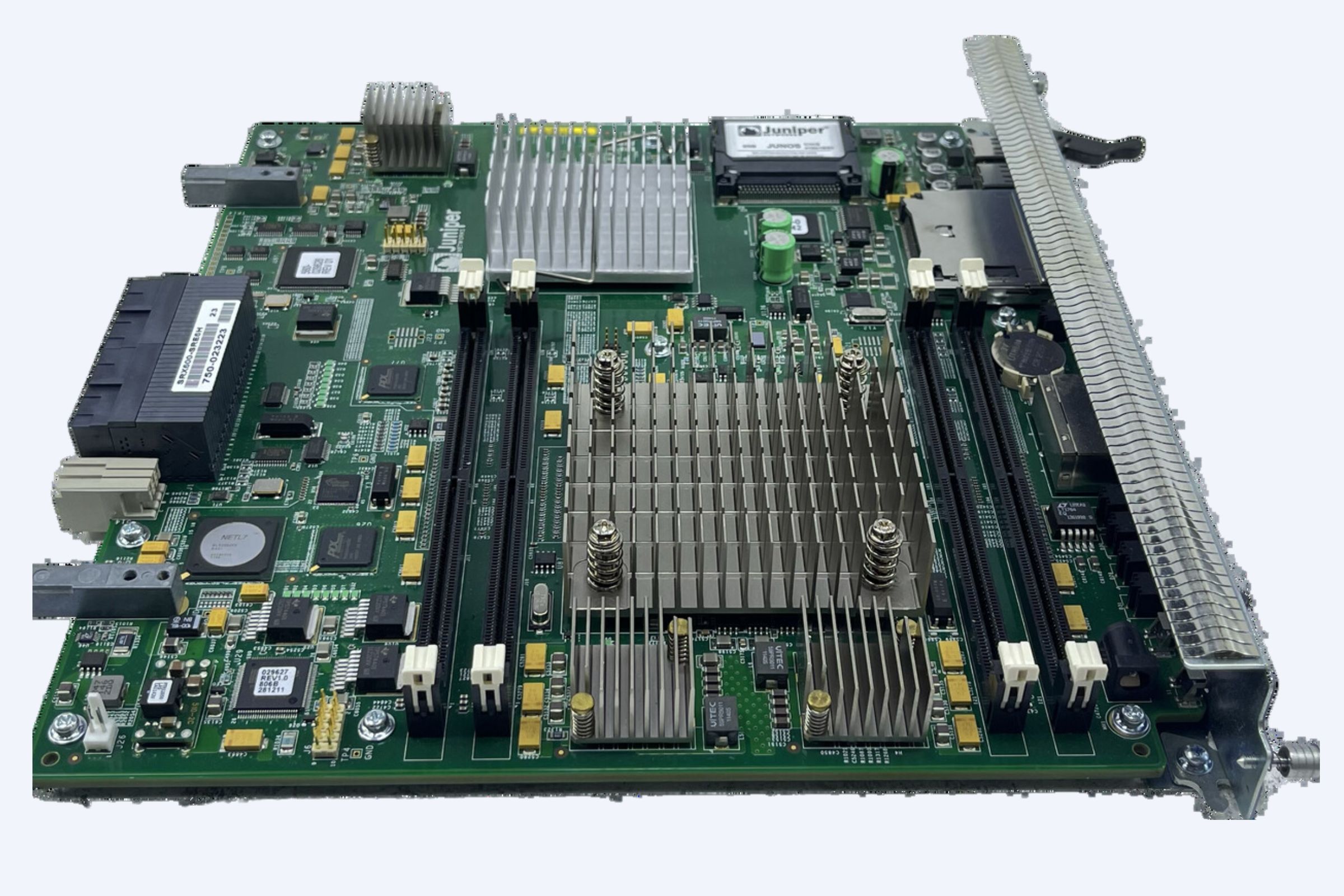

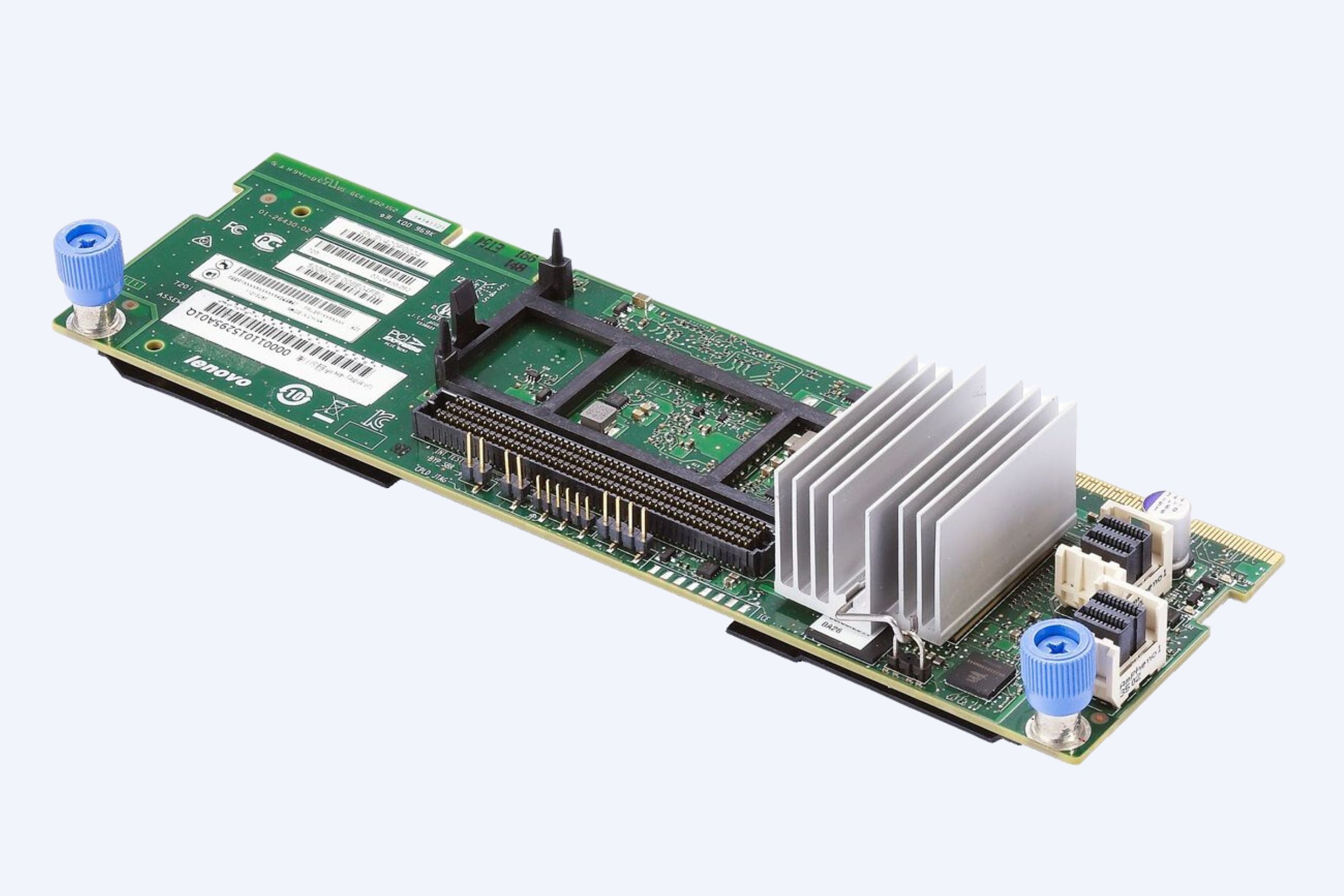

- 엔터프라이즈 지원: 인텔에 최적화된 Kubernetes를 갖춘 IT 관리형 데이터 센터

- 얇고 가벼운 노트북: 25W TDP 미만의 와트당 성능 향상

🛠️ 단계별: AMD에 DeepSeek-R1 배포하기

*(Ryzen AI Max+ 395 + 64GB RAM에서 테스트)*.

드라이버를 설치합니다:

→ AMD Adrenalin 25.1.1+ & ROCm 7.x 6

LM Studio(v0.3.8+)를 다운로드하고 증류된 R1 모델을 선택합니다:

모델: DeepSeek-R1-Distill-Qwen-32B

Quant: Q4_K_M(속도/정확도 균형에 권장)

LM Studio에서 GPU 오프로드를 최대화하세요:

# LM 스튜디오 설정에서:

GPU_OFFLOAD = "최대" # NPU + iGPU + RAM 사용

로드 → 채팅! *(첫 번째 토큰 지연 시간 0.7초)* 6

🔮 향후 전망: CPU 기반 R1 배포가 나아갈 방향

- AMD의 선두가 점점 더 커집니다: MI350X GPU는 이제 NVIDIA B200 810보다 빠르게 R1 30%를 실행합니다.

- 인텔의 반격: "팬서 레이크" CPU(2025년 말)는 3배의 NPU 향상을 약속합니다.

- 하이브리드 클라우드-CPU 워크플로: CPU의 가벼운 R1-8B + 클라우드의 무거운 작업

💎 결론

고성능, 비용 효율적인 DeepSeek-R1 배포를 위해:

- 특히 Linux/ROCm 설정에서 AMD Ryzen AI Max+ 395가 오늘의 승자입니다.

Windows 중심 또는 전력 제약이 있는 에지 사용:

- 인텔 루나 레이크는 여전히 실행 가능하지만 원시 처리량에서 뒤처집니다.

전문가 팁: AMD CPU와 RX 7000 GPU(예: 7900 XTX)를 페어링하여 데스크탑 규모 6에서 32B+ R1 모델을 실행하세요.

🔍 이것이 중요한 이유

DeepSeek-R1은 단순한 LLM이 아닙니다. OpenAI o1보다 96.4% 더 저렴하면서도 추론 능력은 동등합니다1. CPU/GPU 혼합에 최적으로 배포하면 GPU 군비 경쟁에서 소외된 스타트업, 연구자, 글로벌 개발자에게 AI를 개방할 수 있습니다.

인텔은 아직 출시되지 않았지만 2025년에는 온디바이스 R1을 위한 실용적인 선택은 AMD입니다.

(배포에 도움이 필요하신가요? 하드웨어 구성을 안내해 드릴 수 있습니다!)