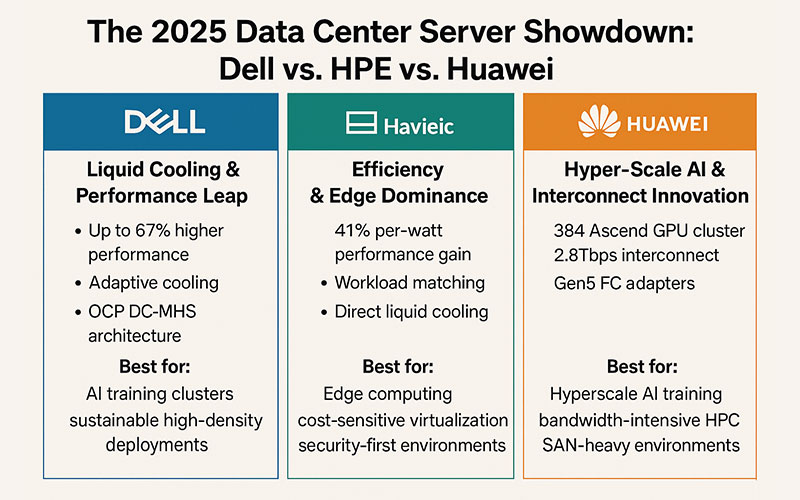

2025年データセンター・サーバー対決:デル対HPE対ファーウェイ

AI、ハイブリッド・クラウド、リアルタイム・アナリティクスの容赦ない急増により、サーバーの選定はインフラの決定事項から戦略的なビジネス上の必須事項へと変化しています。2025年に向けて、デル、HPE、ファーウェイはそれぞれデータセンター近代化のための明確な道筋を提示しているが、自社のワークロードにそれぞれの強みを合わせることが重要である。ここでは、各社が提供する製品を読み解く方法を紹介する。

⚙️ 中核の戦線:テクノロジーと建築

Dell PowerEdge:液冷とパフォーマンスの飛躍

デルの最新PowerEdgeサーバー(R770など)は、インテルXeon 6 Pコア・プロセッサーを活用し、最大67%の高性能を実現すると同時に、50%6のエネルギー・コスト削減を実現します。真のエースとは?適応型冷却です:

- スマート冷却2.0:AIによるエアフロー最適化+多相液冷(コールドプレート/液浸)により、新規構築時のPUEを1.02に低減210。

- OCP DC-MHSアーキテクチャ:モジュール設計により、AI工場の拡張が簡素化され、最大480kWのラックに対応し、熱の無駄がほとんどありません10。

最適AIトレーニングクラスター、持続可能な高密度デプロイメント。

HPE ProLiant Gen12:効率性とエッジの優位性

インテル® Xeon 6を搭載したHPEのGen12サーバーは、ワット当たり41%の性能向上を達成し、Gen10サーバーの7倍をGen12サーバー1台で置き換えることができます37。主なイノベーション

- ワークロードマッチング:特定のアプリケーション向けにBIOSを自動最適化(例:ベンチマークで仮想化を321%向上)5。

- 直接液体冷却(DLC):スペースや電力に制約のあるエッジサイト用オプション3。

- シリコンからソフトウェアへのセキュリティ:分散エッジ・ネットワークに不可欠な、ファームウェア攻撃をブロックするハードウェアに根ざしたトラスト・チップ5。

最適エッジコンピューティング、コスト重視の仮想化、セキュリティ優先の環境。

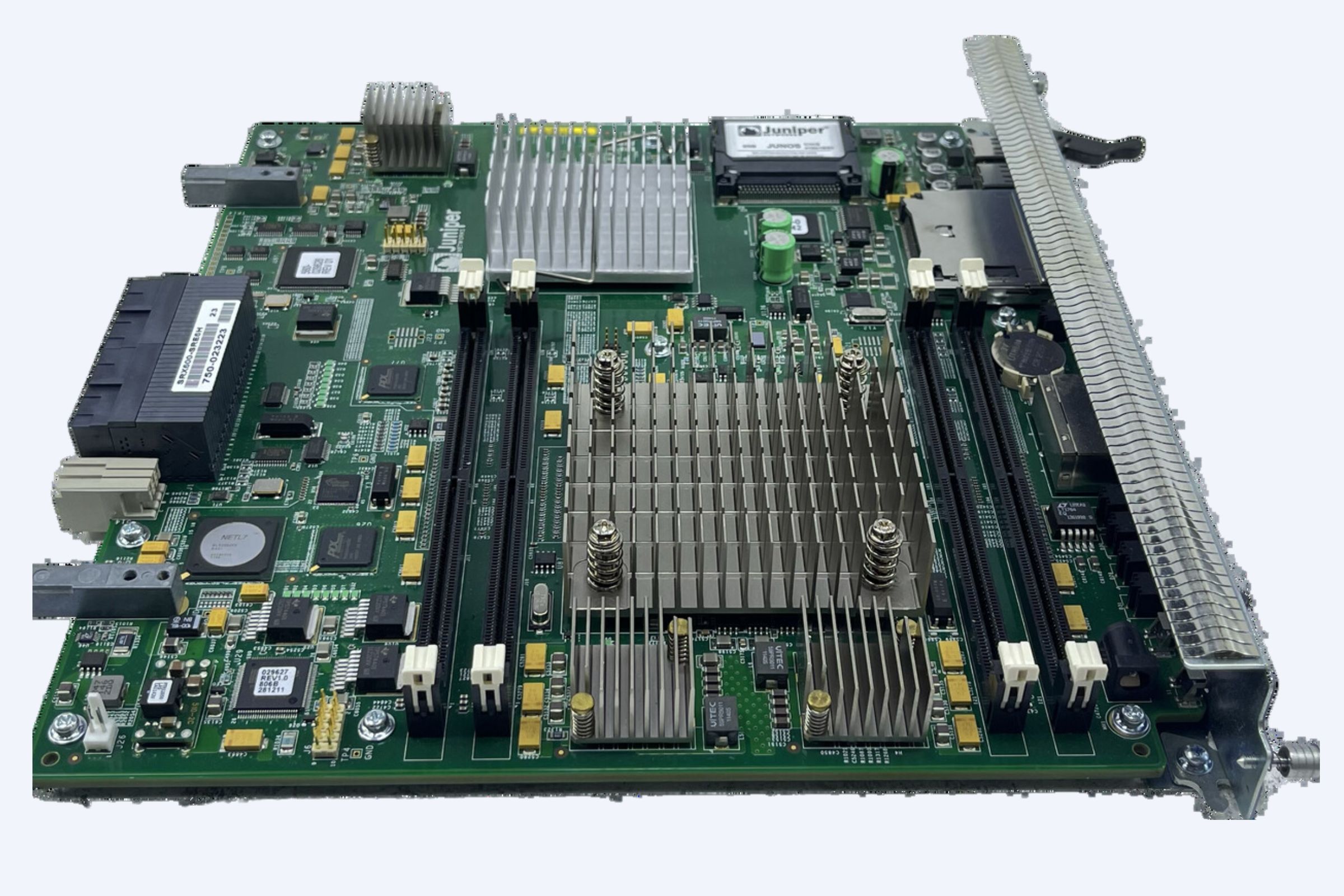

ファーウェイ:ハイパースケールAIと相互接続イノベーション

ファーウェイは、CloudMatrix 384「スーパーノード」でAIインフラ競争をターゲットにしている。これは、384のAscend GPUを1つのクラスタに搭載し、300PFlops(NVIDIAのNVL72より67%高い)を実現する8。特筆すべき利点

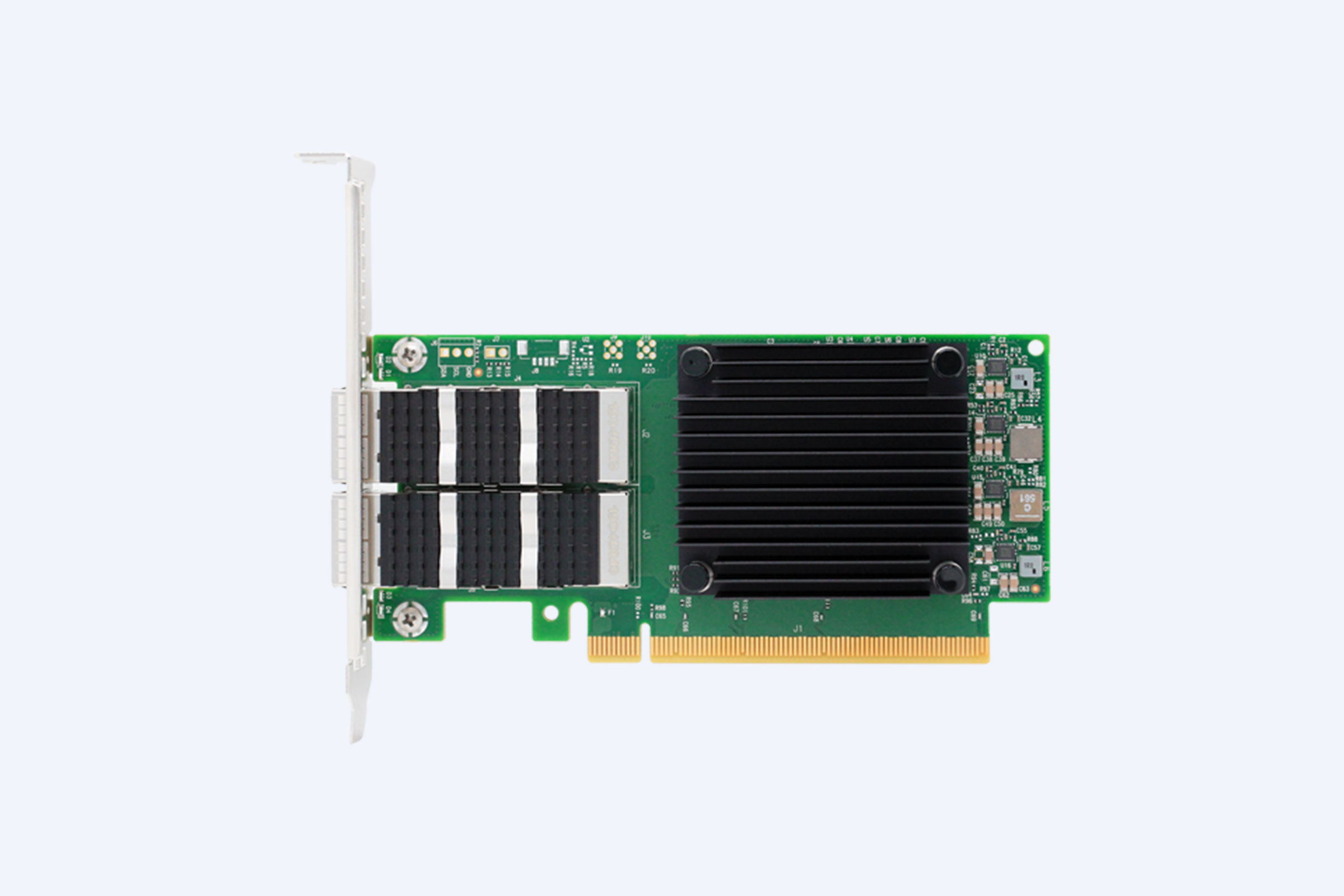

- 2.8Tbpsインターコネクト:6,812x400G光モジュールにより、ほぼ瞬時のGPU通信が可能になり、LLMトレーニングの中断を削減8。

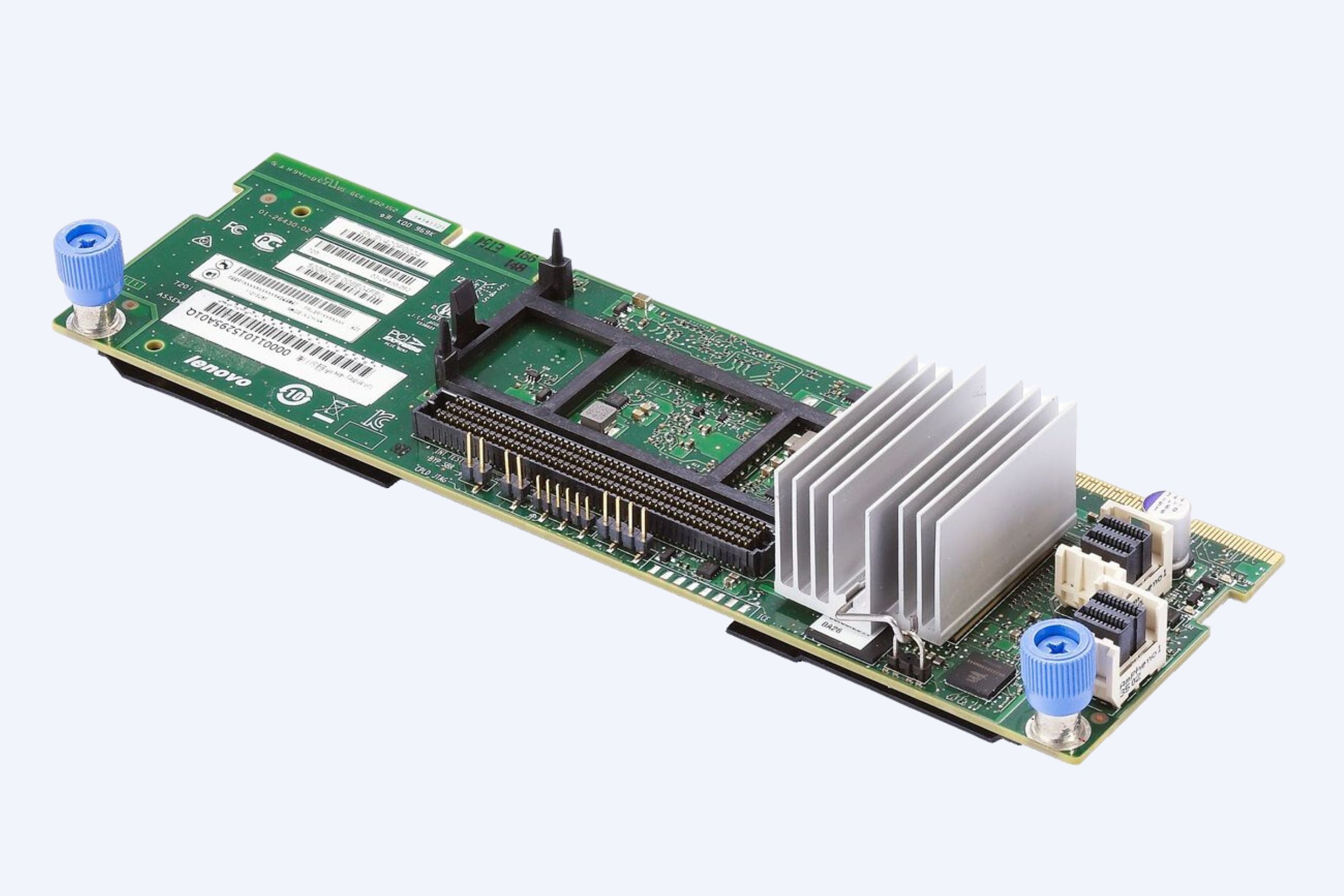

- Gen5 FCアダプタ:QLogic社との共同開発により、I/Oスループットが8Gbファイバーチャネルの3倍となり、リアルタイム分析に最適4。

最適ハイパースケールのAIトレーニング、帯域幅を重視するHPC、SANを多用する環境。

⚖️ 比較分析:トレードオフを打破する

有能な戦略的サーバー選択のための主要指標(2025年)

| 基準 | デル・パワーエッジ | HPE ProLiant Gen12 | ファーウェイ |

|---|---|---|---|

| ピーク演算密度 | 24K-27Kコア/ラック(M7725) | ~デルに比べ40%少ないコア数 | 384GPU/スーパーノード |

| エネルギー効率 | 50%のTCO削減6 | 65%パワーセーブ3 | より高いワット/FLOP8 |

| 冷却技術 | 液浸対応(PUE 1.02) | Air/DLCハイブリッド | 従来の空気/液体 |

| セキュリティ | iDRAC 10 + ゼロ・トラスト | 360°ファームウェアアーマー5 | マルチポート・アイソレーション |

| 理想的な仕事量 | AI工場、グリーンDC | エッジ、ミッドマーケットクラウド | LLMトレーニング、膨大なデータ |

🎯 業種別サーバーのマッチング:使用例

- 金融サービス:ファーウェイの低レイテンシーFCアダプタがリスク・モデリングを高速化し、HPEのセキュリティがトランザクション・システムを保護する45。

- ヘルスケアと研究:デルの液冷ラックはゲノミクス・シミュレーション(TACCのスーパーコンピューターなど)2に対応し、HPEのDLCはコンパクトなラボのエッジにフィットする。

- 製造/エッジAI:HPE Gen12のコンパクトな形状とワークロードの自動化は、工場現場の推論に適している。

- パブリッククラウド・プロバイダーデルのOCPラックがスケーラブルなAIaaSを実現し、ファーウェイのスーパーノードがGPU利用率を最大化し、レンタル可能な推論を実現する10。

ᔮ 将来のための投資:3つの戦略転換

- 液冷が必須CPU/GPUのTDPが1.4kWを超えるため、デルの段階的液浸とHPEのDLCは、40kW超のラックに不可欠である210。

- 分散型コンポーザブル・インフラストラクチャ:デルのIR7000とファーウェイのCloudMatrixは、CPU/GPU/ストレージのスケーリングを可能にし、モノリシックなロックインを回避する810。

- AIに最適化されたシリコン:NPU(Xeon 6など)を搭載したサーバーを優先することで、一般的なCPUに比べて2~4倍の推論効果が得られる37。

💎 結論:意思決定の枠組み

- デルをお選びください:持続可能性、AI密度、液冷先物がロードマップの大半を占める場合。

- 次のような場合は、HPEをお選びください:エッジの統合、ワークロードの柔軟性、万全のセキュリティは譲れません。

- 次のような場合にファーウェイをお選びください:中国/APACにフォーカスしたLLMを構築する場合、またはペタバイト規模のストレージ・スループットが必要な場合。

最後のヒント繰り返しテストを行う!AIトレーニングにはデルのPowerEdgeを、ブランチサイトにはHPEのGen12を、SANを多用するアプリケーションにはファーウェイを試験的に導入してみよう。ハイブリッド・インフラは今や例外ではなく、当たり前のものとなっている。

2025年のデータセンターは、生のパワーとアーキテクチャの俊敏性を融合したサーバーを求めている。デルは持続可能なハイパフォーマンスで、HPEは適応性の高いエッジ効率で、そしてファーウェイはブルートフォースAIスケールでリードしています。ワークロードのDNAが勝敗を決めます。