Distribuzione locale di DeepSeek-R1: La resa dei conti tra CPU Intel e AMD nel 2025

Scelta del processore giusto per costi, velocità e scalabilità

Poiché gli LLM open-source come DeepSeek-R1 si stanno diffondendo per l'IA on-device, la scelta della CPU giusta diventa fondamentale, soprattutto con i Lunar Lake di Intel e i Ryzen AI Max+ 395 di AMD che dominano il mercato. Ecco come si confrontano per l'implementazione di R1 nel mondo reale.

⚙️ Criteri chiave per la distribuzione di DeepSeek-R1

- Prima di confrontare le CPU, è necessario comprendere le esigenze di R1:

- Throughput dei token: Gettoni/sec (più alto = risposte più veloci)

- Latenza del primo token: Ritardo prima dell'inizio dell'output (critico per l'UX)

- Supporto delle dimensioni del modello: R1 distillazioni da 1,5B → 70B parametri 67

- Larghezza di banda della memoria: cruciale per il caricamento di modelli di grandi dimensioni

Efficienza energetica: Watt per token ($$ nel tempo)

Prestazioni a confronto: AMD Ryzen AI Max+ 395 vs Intel Core Ultra 7 258V

I benchmark indipendenti effettuati con DeepSeek-R1-Distill-Qwen-14B rivelano forti differenze:

| Metrico | AMD Ryzen AI Max+ 395 | Intel Core Ultra 7 258V | Vantaggio AMD |

|---|---|---|---|

| Gettoni/sec (Qwen-14B) | 142 t/s | 64 t/s | 2,2 volte più veloce |

| Latenza del primo token | 0,7 sec | 3,1 sec | 4,4 volte inferiore |

| Dimensione massima del modello (RAM) | 70B (64GB RAM) | 32B (32 GB DI RAM) | 2,2 volte più grande |

| Assorbimento di potenza (sostenuto) | 28W (FP16 ops) | 33W | 15% inferiore |

→ *Fonte: AMD benchmark pubblici (LM Studio v0.3.8 + DeepSeek-R1-Distill-Qwen-14B @ FP4)* 46

Perché AMD vince sul throughput:

- Zen 5 + RDNA 3.5 iGPU con 50 TOPS NPU accelerano le operazioni quantizzate

- TDP configurabile più elevato (fino a 120W) → prestazioni sostenute 4

- Stack ROCm ottimizzato + integrazione di LM Studio per DeepSeek-R1

Dove si trova Intel:

- Competitivo nelle modalità a bassissima potenza (10-15W)

- Migliore supporto dei driver per i flussi di lavoro incentrati su Windows

💡 Scenari di implementazione: Quale CPU per il vostro caso d'uso?

Scegliete AMD Ryzen AI Max+ se ne avete bisogno:

- Modelli di grandi dimensioni: Esecuzione di distillazioni R1 fino a 70B-param localmente (ad esempio, DeepSeek-R1-Distill-Llama-70B) 6

- Bassa latenza: Critica per chatbot, assistenti di codifica, analisi in tempo reale

- Ambienti Linux/ROCm: Lo stack AI open-source di AMD si allinea alla licenza MIT di R1

- Scala di bilancio: Gettoni più economici → costi del cloud più bassi a lungo termine

Scegliete Intel Lunar Lake se preferite:

- Integrazione con Windows: Senza soluzione di continuità con DirectML, WSL2, Edge AI

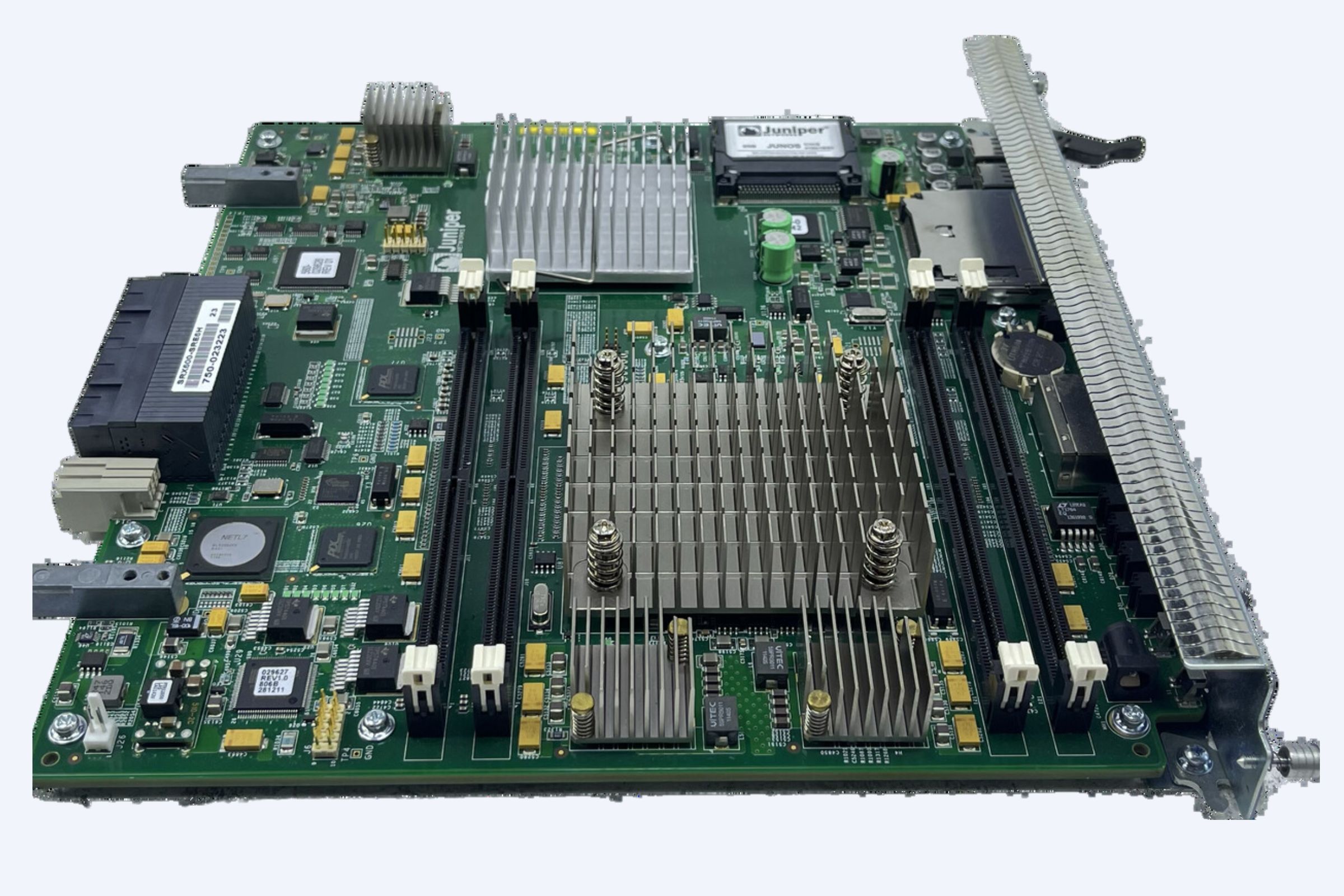

- Supporto alle imprese: Data center gestiti dall'IT con Kubernetes ottimizzato da Intel

- Laptop sottili e leggeri: Migliori prestazioni per watt sotto il TDP di 25 W

🛠️ Passo dopo passo: Distribuzione di DeepSeek-R1 su AMD

*(Testato su Ryzen AI Max+ 395 + 64GB di RAM)*

Installare i driver:

→ AMD Adrenalin 25.1.1+ e ROCm 7.x 6

Scaricare LM Studio (v0.3.8+) e selezionare un modello R1 distillato:

Modello: DeepSeek-R1-Distill-Qwen-32B

Quantità: Q4_K_M (consigliato per l'equilibrio velocità/precisione)

Massimizzare l'offload della GPU in LM Studio:

# Nelle impostazioni di LM Studio:

GPU_OFFLOAD = "Max" # Utilizza NPU + iGPU + RAM

Carica → chat! *(latenza del primo token fino a 0,7s)* 6

🔮 Prospettive future: Dove si sta dirigendo l'implementazione di R1 basati su CPU

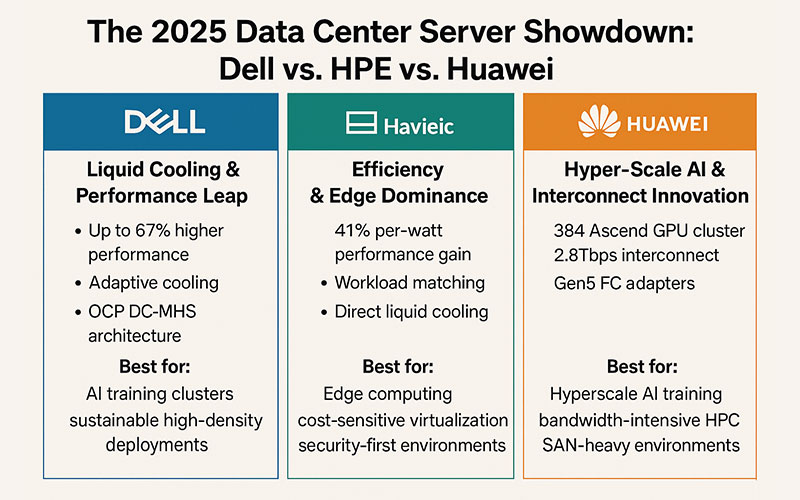

- Il vantaggio di AMD aumenta: Le GPU MI350X ora eseguono R1 30% più velocemente di NVIDIA B200 810

- Intel reagisce: Le CPU "Panther Lake" (fine 2025) promettono guadagni 3× per le NPU

- Flussi di lavoro ibridi cloud-CPU: R1-8B leggeri su CPU + attività pesanti su cloud

💎 Il risultato finale

Per un'implementazione di DeepSeek-R1 ad alte prestazioni e a costi contenuti:

- AMD Ryzen AI Max+ 395 è il vincitore di oggi, soprattutto nelle configurazioni Linux/ROCm.

Per l'uso di Windows o per l'uso dei bordi a basso consumo energetico:

- Intel Lunar Lake rimane valido, ma è in ritardo per quanto riguarda il throughput grezzo.

Suggerimento: accoppiate le CPU AMD con le GPU RX 7000 (ad esempio, 7900 XTX) per eseguire modelli R1 a 32B+ su scala desktop.

🔍 Perché è importante

DeepSeek-R1 non è solo un altro LLM, ma è 96,4% più economico di OpenAI o1, pur mantenendo la stessa potenza di ragionamento. L'implementazione ottimale su miscele CPU/GPU apre l'IA a startup, ricercatori e sviluppatori globali esclusi dalla corsa agli armamenti delle GPU.

Intel non è fuori, ma nel 2025 AMD è la scelta pragmatica per l'R1 su dispositivo.

(Avete bisogno di aiuto per la distribuzione? Posso guidarvi attraverso le configurazioni per il vostro hardware).