Déploiement local de DeepSeek-R1 : L'épreuve de force entre Intel et AMD en 2025

Choisir le bon processeur en fonction du coût, de la vitesse et de l'évolutivité

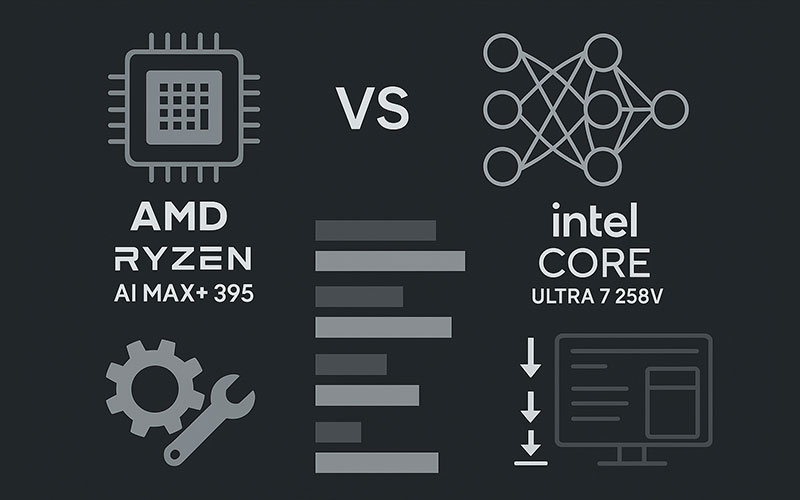

Alors que les LLM open-source tels que DeepSeek-R1 gagnent du terrain pour l'IA sur appareil, le choix du bon processeur devient critique - en particulier avec le Lunar Lake d'Intel et le Ryzen AI Max+ 395 d'AMD qui dominent le marché. Voici comment ils se comparent pour un déploiement R1 dans le monde réel.

⚙️ Critères clés pour le déploiement de DeepSeek-R1

- Avant de comparer les CPU, il faut comprendre les exigences de R1 :

- Débit de jetons : Jetons/sec (plus élevé = réponses plus rapides)

- Latence du premier jet : Délai avant le début de la sortie (critique pour l'interface utilisateur)

- Prise en charge de la taille du modèle : Les distillations R1 vont de 1,5B → 70B paramètres 67

- Largeur de bande de la mémoire : cruciale pour le chargement de grands modèles

Efficacité énergétique : Watts par jeton ($$ au fil du temps)

⚡ Face-à-face des performances : AMD Ryzen AI Max+ 395 vs Intel Core Ultra 7 258V

Des tests indépendants utilisant DeepSeek-R1-Distill-Qwen-14B révèlent des différences flagrantes :

| Métrique | AMD Ryzen AI Max+ 395 | Intel Core Ultra 7 258V | Avantage AMD |

|---|---|---|---|

| Jetons/sec (Qwen-14B) | 142 t/s | 64 t/s | 2,2 fois plus rapide |

| Temps de latence du premier jet | 0,7 sec | 3.1 sec | 4,4 fois plus faible |

| Taille maximale du modèle (RAM) | 70B (64GB RAM) | 32B (32GB RAM) | 2,2 fois plus grand |

| Puissance absorbée (soutenue) | 28W (FP16 ops) | 33W | 15% inférieur |

→ *Source : Benchmarks publics AMD (LM Studio v0.3.8 + DeepSeek-R1-Distill-Qwen-14B @ FP4)* 46

Pourquoi AMD gagne en débit :

- Zen 5 + RDNA 3.5 iGPU avec 50 TOPS NPU accélère les opérations quantifiées

- TDP configurable plus élevé (jusqu'à 120 W) → performances soutenues 4

- Pile ROCm optimisée + intégration de LM Studio pour DeepSeek-R1

Les points forts d'Intel :

- Compétitif dans les modes à très faible consommation (10-15W)

- Meilleure prise en charge des pilotes pour les flux de travail centrés sur Windows

💡 Scénarios de déploiement : Quelle unité centrale pour votre cas d'utilisation ?

✅ Choisissez AMD Ryzen AI Max+ si vous en avez besoin :

- Grands modèles : Exécutez localement jusqu'à 70B-param distillations R1 (par exemple, DeepSeek-R1-Distill-Llama-70B) 6

- Faible latence : Essentiel pour les chatbots, les assistants de codage et les analyses en temps réel.

- Environnements Linux/ROCm : La pile IA open-source d'AMD s'aligne sur la licence MIT de R1

- Échelle budgétaire : Jetons moins chers → coûts de cloud moins élevés à long terme

Choisissez Intel Lunar Lake si vous préférez :

- Intégration de Windows : Intégration transparente avec DirectML, WSL2, Edge AI

- Soutien aux entreprises : Centres de données gérés par l'informatique avec Kubernetes optimisé par Intel.

- Ordinateurs portables minces et légers : De meilleures performances par watt sous 25W TDP

🛠️ Pas à pas : Déploiement de DeepSeek-R1 sur AMD

*(Testé sur Ryzen AI Max+ 395 + 64GB RAM)

Installer les pilotes :

→ AMD Adrenalin 25.1.1+ & ROCm 7.x 6

Téléchargez LM Studio (v0.3.8+) et sélectionnez un modèle R1 distillé :

Modèle : DeepSeek-R1-Distill-Qwen-32B

Quant : Q4_K_M (recommandé pour l'équilibre vitesse/précision)

Maximiser la décharge du GPU dans LM Studio :

# Dans les paramètres de LM Studio :

GPU_OFFLOAD = "Max" # utilise NPU + iGPU + RAM

Chargement → chat ! *(latence du premier jet aussi basse que 0,7s)* 6

🔮 Perspectives d'avenir : La direction que prend le déploiement R1 basé sur l'unité centrale

- L'avance d'AMD s'accroît : Les GPU MI350X fonctionnent désormais R1 30% plus rapidement que le NVIDIA B200 810

- Intel riposte : Les processeurs "Panther Lake" (fin 2025) promettent des gains NPU 3×.

- Flux de travail hybrides cloud-CPU : tâches légères R1-8B sur l'unité centrale + tâches lourdes sur le nuage

💎 The Bottom Line

Pour un déploiement performant et rentable de DeepSeek-R1 :

- AMD Ryzen AI Max+ 395 est la gagnante du jour - en particulier dans les configurations Linux/ROCm.

Pour une utilisation en périphérie centrée sur Windows ou limitée en puissance :

- Intel Lunar Lake reste viable mais est à la traîne en termes de débit brut.

Astuce : Associez des CPU AMD à des GPU RX 7000 (par exemple, 7900 XTX) pour exécuter des modèles R1 32B+ à l'échelle d'un ordinateur de bureau 6.

🔍 Pourquoi c'est important

DeepSeek-R1 n'est pas un simple LLM - il est 96,4% moins cher qu'OpenAI o1 tout en égalant sa puissance de raisonnement 1. Son déploiement optimal sur des mélanges CPU/GPU ouvre l'IA aux startups, aux chercheurs et aux développeurs mondiaux exclus de la course aux armements GPU.

Intel n'est pas exclu, mais en 2025, AMD est le choix pragmatique pour la R1 sur l'appareil.

(Si vous avez besoin d'aide pour le déploiement, je peux vous aider à configurer votre matériel).